Startup-ul chinezesc AI DeepSeek tocmai a lansat oficial cel mai recent model de limbă mare (LLM), DeepSeek-V3-0324. Cu o capacitate de până la 641 GB, acest model a fost anunțat pe platforma AI Hugging Face fără a fi dezvăluite prea multe informații, în conformitate cu stilul secret despre noile produse pe care compania l-a aplicat mereu până acum.

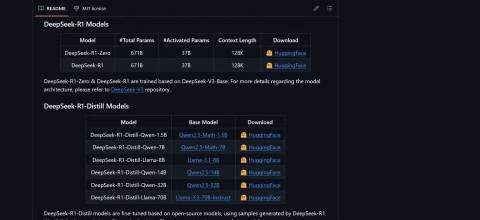

Lucrul special la acest model este licența MIT, care permite utilizarea gratuită în scopuri comerciale. Rezultatele inițiale de referință arată că DeepSeek-V3-0324 este capabil să ruleze pe configurații hardware principale, cum ar fi Mac Studio de la Apple cu cip M3 Ultra. Omul de știință AI Awni Hannun a raportat că a fost posibil să se obțină viteze de procesare de peste 20 de jetoane pe secundă folosind această configurație. Această capacitate de a rula un model de limbă mare pe hardware-ul de bază la sediu este în contrast puternic cu abordarea tradițională de utilizare a infrastructurii masive a centrelor de date pentru a susține modele avansate de IA.

Conform informațiilor de la DeepSeek, testele inițiale au arătat îmbunătățiri semnificative față de versiunile anterioare. Acest model a fost testat riguros de părțile interesate interne și a demonstrat o performanță excelentă, depășind chiar toate celelalte modele concurente și depășind Claude Sonnet 3.5 de la Anthropic în sarcini care nu necesită gândire profundă. Cu toate acestea, spre deosebire de modelele în stil Sonnet care necesită un abonament plătit, DeepSeek-V3-0324 este complet gratuit de descărcat și utilizat.

Din punct de vedere tehnic, DeepSeek-V3-0324 utilizează o arhitectură mixtă de experți (MoE). Se remarcă prin capacitatea sa de a utiliza în mod selectiv aproximativ 37 de miliarde din cei 685 de miliarde de parametri per sarcină, crescând eficiența prin reducerea cerințelor de calcul, menținând în același timp performanța. Acest model aplică, de asemenea, tehnologiile Multi-Head Latent Attention (MLA) și Multi-Token Prediction (MTP), care contribuie la îmbunătățirea memoriei de context și la accelerarea ieșirii.

Utilizatorii pot accesa DeepSeek-V3-0324 prin Hugging Face, interfața de chat și API-ul OpenRouter, precum și platforma de chat DeepSeek, dacă doresc. Furnizorul de servicii de inferență Hyperbolic Labs oferă, de asemenea, acces la model.

Odată cu lansarea DeepSeek-V3-0324, compania continuă să-și afirme poziția în cursa pentru dezvoltarea modelelor de limbaj mari, oferind în același timp o opțiune puternică și accesibilă pentru comunitatea de cercetare și dezvoltare AI. Capacitatea de a rula pe hardware de bază cuplată cu o licență gratuită va deschide cu siguranță multe oportunități practice de aplicare pentru acest model în viitorul apropiat.