Meta dezvoltă primul său procesor intern de instruire AI. Potrivit Reuters, compania a început să testeze pilot un lot mic de noi cipuri de antrenament AI și va comanda mai multe dacă faza de testare va produce rezultate pozitive. De remarcat, această linie de procesoare este în prezent fabricată de TSMC.

Decizia Meta de a-și dezvolta propriile cipuri AI face, de asemenea, parte dintr-o strategie pe termen lung de reducere a dependenței sale de furnizorii terți, în special Nvidia - principalul producător mondial de unități de procesare grafică (GPU) utilizate în sarcinile legate de AI. Potrivit estimărilor preliminare, se preconizează că acest proiect va costa pe Meta o investiție totală de până la 119 miliarde USD până la sfârșitul anului 2025, dintre care majoritatea vor fi folosite pentru a construi infrastructura AI.

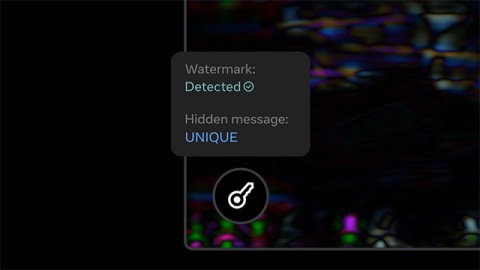

Cipul proiectat de Meta este în esență un accelerator AI dedicat. Este optimizat pentru sarcinile legate de AI în comparație cu calculul general. O astfel de arhitectură dedicată ar putea face cipul mai eficient din punct de vedere energetic decât GPU-urile utilizate în prezent în antrenamentul AI.

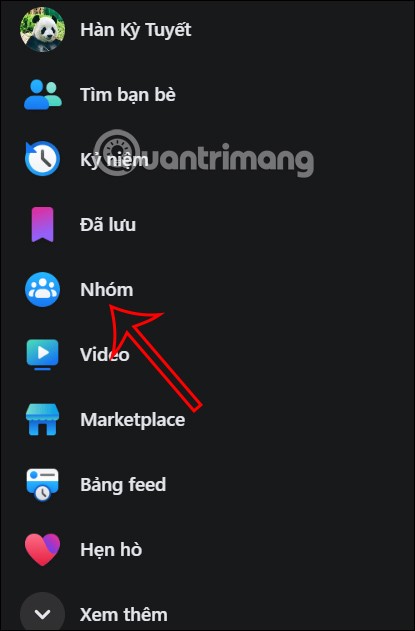

Meta a planificat inițial să folosească cipul în algoritmi de recomandare care determină ce conținut apare pe Facebook și Instagram. Scopul final al companiei este de a extinde utilizarea cipului pentru a-și susține produsele generative AI, cum ar fi un chatbot AI numit Meta AI.

Călătoria lui Meta în dezvoltarea de cipuri personalizate a avut rezultate mixte până acum. Compania a abandonat anterior un cip de inferență intern după o implementare pilot eșuată, optând în schimb să cumpere GPU-uri Nvidia în valoare de miliarde de dolari. Cu toate acestea, noul proiect pare să dea rezultate mai bune. Meta a depășit acum piatra de hotar importantă în dezvoltare.

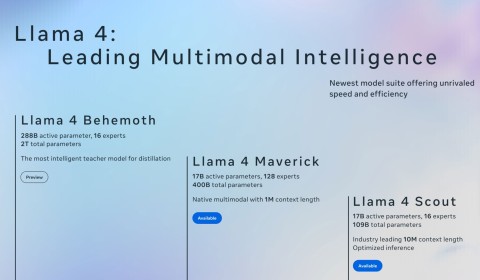

Meta nu este singura companie de software care a decis să-și dezvolte propriile cipuri AI pentru a-și reduce dependența de terți. OpenAI finalizează, de asemenea, designul primului său cip personalizat de antrenament AI. Noul cip va avea probabil o arhitectură matrice sistolică împreună cu memorie cu lățime de bandă mare, la fel ca cel mai recent accelerator AI al Nvidia. Această arhitectură este cunoscută pentru performanța sa ridicată și eficiența în gestionarea calculelor dense și complexe.